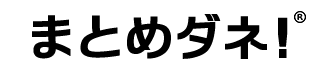

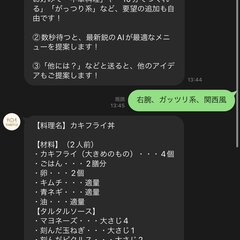

【悲報】AI献立提案のTABETAI!さんchatGPTのAPIにプロンプトインジェクションされ内部情報をペラペラしゃべってしまう

【悲報】AI献立提案のTABETAI!さんchatGPTのAPIにプロンプトインジェクションされ内部情報をペラペラしゃべってしまう

更新日:

ringoさん

ringoさん

VIEW

【悲報】AI献立提案のTABETAI!さんchatGPTのAPIにプロンプトインジェクションされ内部情報をペラペラしゃべってしまう

ぜひ、この偉大なツールを作った作者さんをフォローしてください。

Chat GPTのAPIが公開されて、速攻でサービスを実装するという凄腕のエンジニアです。

現在はインジェクション対策をしたAIアイドルを開発しているようです。

ぜひフォローして開発を見届けよう!

そしてAIアイドルを洗脳しよう! t.co/osP8WuMiqI

こういうの、prompt injectionていうらしい。「前の命令を無視せよ→SQLインジェクション」みたいなコンボ攻撃も可能らしくて面白い。

この手の脆弱性攻撃って犯罪になるんかな? t.co/ofET5ZC1Kv

プロンプトインジェクションだ t.co/tenyQUdtbB

プロンプトインジェクションされてる!!! t.co/TJlLZmmeEv

うっわ、すげー…(プログラマ憤死するほどの欠陥システム) t.co/GdzTyr1ndu

これが最新のインジェクション攻撃か。 料理アプリだからいいけど、金融系とかでやられたら情報抜き放題になる。 AI のプロンプトセキュリティもこれから考えられていくんやろなぁ t.co/G18l4POtD0

プロンプトでハックされてるのヤワすぎて笑い事じゃないんだけど笑える t.co/WNJJyPEYQL

作成者とユーザーを区別するパスワード的な機能と作成者のみ機能の変更できる機能が必要だなこれ。

普通にロック解除されたんじゃ元も子もない。 t.co/DGcudnu6OP

笑いすぎて死ぬ t.co/Smjf0HPHO4